Q:这是RoFormer: Enhanced Transformer with Rotary Position Embedding中的一段话,其中方程1为什么q k v的位置编码用不用的表示,m和n不应该是相同的吗

A:

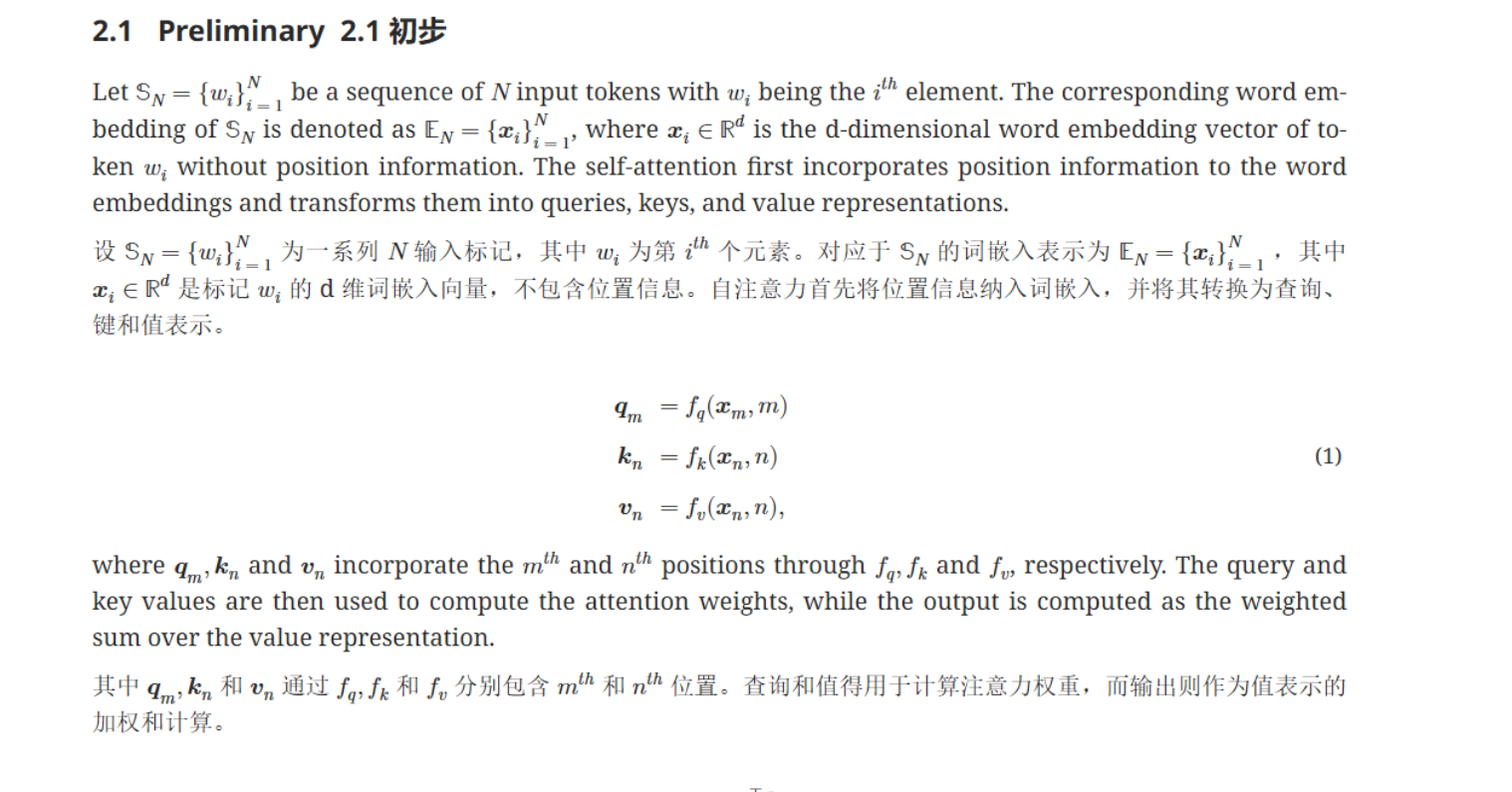

核心问题理解

在自注意力(Self-Attention)中,查询(Query)q 和 键(Key)k 之间是两两比较的,因此它们所携带的位置本来就不应该是相同的。

假如我们有一组序列 \{w_i\}_{i=1}^N,注意力分数是 每个查询和所有键的匹配,即:

\text{Attention}(q_m, k_n)

表示 位置 m 上的查询 和 位置 n 上的键 的匹配。

因此:

查询 q 应该来自 位置 m:q_m = f_q(x_m, m)

键 k 和 值 v 应该来自 位置 n:k_n = f_k(x_n, n), \ v_n = f_v(x_n, n)

2. 为什么 m 和 n 不相等

m 和 n 的区别:

m:当前正在计算注意力输出的那个位置(即 query 的位置)。

n:用来参与注意力分数计算并作为加权求和的其他所有位置(即 key 和 value 的位置)。

举个简单例子,假如我们对序列位置 m = 2 做注意力:

\sum_{n=1}^{N} \alpha_{m,n} v_n

其中注意力权重 \alpha_{m,n} 来自:

\alpha_{m,n} \propto \exp(q_m k_n)

3. 总结

所以:

m 和 n 不相同是因为:q 属于目标位置 m,k 和 v 属于所有位置 n。

Attention 本质是 "位置 m 去 attend 所有 n 的加权",因此必须用不同的 m 和 n。

4. 补充:为什么每个 q/k/v 都显式包含位置信息

在 RoFormer 或任何位置编码相关的机制中,通常需要在词向量(embedding)的基础上显式加上或融合位置信息,因此公式才写成:

q_m = f_q(x_m, m), \quad k_n = f_k(x_n, n), \quad v_n = f_v(x_n, n)

表示 词向量 + 位置信息 的融合(可能是简单相加,也可能是旋转位置编码)。

🔑 关键 takeaway:

m 是 query 的位置,n 是 key/value 的位置,attention 本身需要比较不同位置,所以 不可能都是 m。

每个位置嵌入 (q/k/v) 都需要带位置信息,是为了让模型知道 "谁在 attend 谁"。

Q:这个方程中计算的是q k v而不是q*k

A:

确实,提到的那一行公式:

q_m = f_q(x_m, m), \quad k_n = f_k(x_n, n), \quad v_n = f_v(x_n, n)

这确实是 计算 q/k/v 的过程,而 不是 q 和 k 的点积(即 attention score)。

所以问题来了:

既然是单独计算 q/k/v,为什么 q 带 m,k/v 带 n?m 和 n 不应该相等吗?

🔑 关键理解:m 和 n 的角色不同

虽然 q/k/v 的计算 本质上是 针对各自位置,但 公式写法上明确区分 m 和 n 是为了后续 Attention 机制 的逻辑清晰。

一、逐步展开自注意力机制

先计算 q/k/v:

对于序列中的每一个位置 i,都会得到:

q_i = f_q(x_i, i), \quad k_i = f_k(x_i, i), \quad v_i = f_v(x_i, i)

注意:这里只是针对单个位置 i 的 q/k/v,没有 m 和 n 的概念,所有位置都会这样做。

在后续 Attention 分数计算时,m 和 n 的意义才出现:

当我们对 位置 m 做注意力时:

\alpha_{m,n} = \text{softmax}_n \left( \frac{q_m \cdot k_n}{\sqrt{d}} \right)

然后:

\text{Attention output at } m = \sum_{n=1}^N \alpha_{m,n} v_n

所以 m 是当前 query 的位置,n 是所有被 attend 的键和值的位置。

二、那为什么公式 (1) 中就出现 m 和 n?

为了强调 q/k/v 在后续 attention 中的角色。

实际上 公式 (1) 是在告诉你:

q_m:最终会作为第 m 个 query。

k_n, v_n:最终作为第 n 个 key 和 value。

所以即使本质上 q/k/v 都是通过相应位置的 x 和位置信息得到的,作者用 m 和 n 提前为后续 attention 公式埋下伏笔,让你能清楚地知道:

"我算出来的 q_m 是给位置 m 用的。"

"我算出来的 k_n, v_n 是给位置 n 用的。"

🔑 总结

✅ 结论一句话总结:

公式 (1) 中 m 和 n 的区分 是为了帮助你理解后续 attention 的过程,虽然 q/k/v 的计算本身按位置来看只是 x_i 和位置 i 的函数,写成 m 和 n 是为了强调 "这些量最终在 attention 里扮演的角色"。

Q:是第m个token的意思吗

A:

对!这里的 qₘ 确实就是指 第 m 个 token 的 query 表示。

我们可以这么理解:

🌸 更直白的解释:

假设有一串 token,比如:

Token 序列:w₁, w₂, w₃, ..., w_N对于每一个 token w_m,都会生成属于它自己的:

Query:q_m

Key:k_m

Value:v_m

所以:

q_m = f_q(x_m, m)

就表示:

“这是序列中第 m 个 token 的 query 表示。”

同理,k_n, v_n 是第 n 个 token 的 key 和 value 表示。

🌸 为什么 m 和 n 可能不相等?

因为:

在做 注意力 (Attention) 时,

我们关心的是 第 m 个 token 如何关注(attend to)其他所有 token。

因此,第 m 个 token 的 query q_m,要去和所有的 key k_n 做点积,计算注意力分数:

\alpha_{m,n} \propto \exp \left( \frac{q_m \cdot k_n}{\sqrt{d}} \right)

最后再用这些分数去加权所有 value v_n,得出位置 m 的最终表示。

✅ 总结成一句话:

qₘ 就是第 m 个 token 的 query 表示,用来对其他所有 key 做 attention;kₙ 和 vₙ 则是第 n 个 token 的 key 和 value 表示,供 qₘ 去关注。